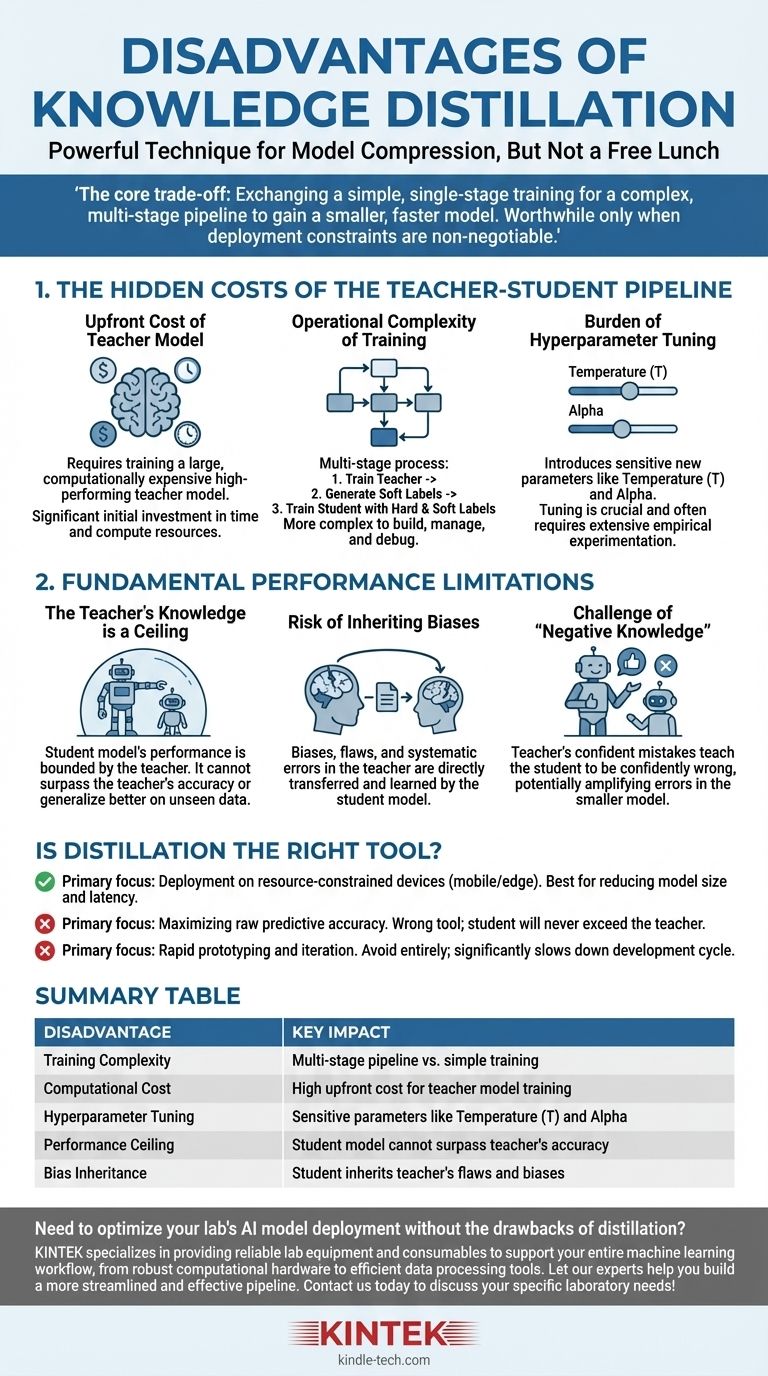

Obwohl die Wissensdestillation eine leistungsstarke Technik zur Modellkompression ist, ist sie kein Allheilmittel. Die Hauptnachteile sind der erhebliche Anstieg der Trainingskomplexität und der Rechenkosten, die Einführung empfindlicher neuer Hyperparameter und die harte Leistungsobergrenze, die durch die Qualität des Lehrermodells vorgegeben wird.

Der Kernkompromiss der Destillation ist klar: Sie tauschen einen einfacheren, einstufigen Trainingsprozess gegen eine komplexe, mehrstufige Pipeline ein, um ein kleineres, schnelleres Modell zu erhalten. Diese Investition in Komplexität lohnt sich nur, wenn Einsatzbeschränkungen wie Latenz oder Speicherplatz nicht verhandelbar sind.

Die versteckten Kosten der Lehrer-Schüler-Pipeline

Die unmittelbarsten Nachteile der Destillation sind nicht konzeptioneller, sondern praktischer Natur. Sie betreffen den zusätzlichen Zeit-, Ressourcen- und Engineering-Aufwand, der für die Verwaltung eines komplexeren Trainings-Workflows erforderlich ist.

Die Vorabkosten des Lehrermodells

Bevor Sie überhaupt mit der Destillation beginnen können, benötigen Sie ein leistungsstarkes Lehrermodell. Dieses Modell ist naturgemäß groß und rechenintensiv im Training.

Diese anfängliche Trainingsphase stellt einen erheblichen, nicht unerheblichen Kostenfaktor in Bezug auf Zeit und Rechenressourcen dar, der bezahlt werden muss, bevor das "eigentliche" Training des Schülermodells beginnen kann.

Die betriebliche Komplexität des Trainings

Die Destillation ist ein mehrstufiger Prozess, im Gegensatz zum Standard-Modelltraining. Der typische Workflow ist:

- Trainieren Sie das große Lehrermodell bis zur Konvergenz.

- Führen Sie eine Inferenz mit dem Lehrermodell auf Ihrem gesamten Trainingsdatensatz durch, um die "weichen Labels" oder Logits zu generieren.

- Trainieren Sie das kleinere Schülermodell unter Verwendung sowohl der ursprünglichen "harten Labels" als auch der weichen Labels des Lehrers.

Diese Pipeline ist von Natur aus komplexer zu erstellen, zu verwalten und zu debuggen als ein Standard-Trainingsskript.

Die Last der Hyperparameter-Abstimmung

Die Destillation führt einzigartige Hyperparameter ein, die den Wissenstransferprozess steuern, und sie erfordern eine sorgfältige Abstimmung.

Am kritischsten ist die Temperatur (T), ein Wert, der verwendet wird, um die Wahrscheinlichkeitsverteilung der Ausgaben des Lehrers zu glätten. Eine höhere Temperatur offenbart nuanciertere Informationen über die "Argumentation" des Lehrers, aber das Finden des optimalen Wertes ist ein empirischer Prozess.

Ein weiterer wichtiger Hyperparameter ist Alpha, der den Verlust aus den weichen Labels des Lehrers mit dem Verlust aus den Ground-Truth-Hard-Labels ausgleicht. Dieses Gleichgewicht ist entscheidend für den Erfolg und erfordert oft umfangreiche Experimente.

Die grundlegenden Leistungseinschränkungen

Über die praktischen Kosten hinaus hat die Destillation inhärente Einschränkungen, die das Potenzial des endgültigen Schülermodells begrenzen.

Das Wissen des Lehrers ist eine Obergrenze

Die Leistung eines Schülermodells ist grundsätzlich durch das Wissen seines Lehrers begrenzt. Der Schüler lernt, die Ausgabeverteilung des Lehrers nachzuahmen.

Daher kann der Schüler den Lehrer weder in der Genauigkeit übertreffen noch auf ungesehenen Daten besser generalisieren. Er kann lediglich hoffen, eine hoch effiziente Annäherung an die Fähigkeiten des Lehrers zu werden.

Das Risiko der Vererbung von Verzerrungen

Alle Verzerrungen, Fehler oder systematischen Irrtümer, die im Lehrermodell vorhanden sind, werden direkt auf das Schülermodell übertragen und von diesem gelernt.

Die Destillation "reinigt" das Wissen nicht; sie überträgt es lediglich. Wenn der Lehrer eine Voreingenommenheit gegenüber einer bestimmten Demografie oder eine Schwäche in einem bestimmten Datenbereich hat, wird der Schüler genau dieselbe Schwäche erben.

Die Herausforderung des "negativen Wissens"

Wenn das Lehrermodell bei einer bestimmten Vorhersage zuversichtlich falsch liegt, wird es dem Schüler beibringen, ebenfalls zuversichtlich falsch zu sein.

Dies ist potenziell schädlicher als ein Modell, das einfach unsicher ist. Der Destillationsprozess kann die Fehler des Lehrers verstärken und sie in das kleinere, effizientere Modell einbacken, wo sie möglicherweise schwerer zu erkennen sind.

Ist Destillation das richtige Werkzeug für Ihr Ziel?

Letztendlich hängt die Entscheidung, Destillation zu verwenden, vollständig vom primären Ziel Ihres Projekts ab.

- Wenn Ihr Hauptaugenmerk auf der Bereitstellung in ressourcenbeschränkten Umgebungen (wie mobilen oder Edge-Geräten) liegt: Destillation ist eine führende Technik, um die notwendige Reduzierung der Modellgröße und Latenz zu erreichen, vorausgesetzt, Sie können sich die anfängliche Trainingskomplexität leisten.

- Wenn Ihr Hauptaugenmerk auf der Maximierung der reinen Vorhersagegenauigkeit liegt: Destillation ist das falsche Werkzeug. Ihre Bemühungen sind besser darauf verwendet, das bestmögliche eigenständige Modell zu trainieren, da der Schüler die Leistung des Lehrers niemals übertreffen wird.

- Wenn Ihr Hauptaugenmerk auf schnellem Prototyping und Iteration liegt: Vermeiden Sie Destillation vollständig. Die mehrstufige Pipeline und die komplexe Hyperparameter-Abstimmung werden Ihren Entwicklungs- und Experimentierzyklus erheblich verlangsamen.

Das Verständnis dieser Nachteile ermöglicht es Ihnen, die Wissensdestillation strategisch einzusetzen und sie als spezialisiertes Werkzeug zur Optimierung zu erkennen, nicht als universelle Methode zur Verbesserung.

Zusammenfassungstabelle:

| Nachteil | Wesentliche Auswirkung |

|---|---|

| Trainingskomplexität | Mehrstufige Pipeline vs. einfaches Training |

| Rechenkosten | Hohe Vorabkosten für das Training des Lehrermodells |

| Hyperparameter-Abstimmung | Empfindliche Parameter wie Temperatur (T) und Alpha |

| Leistungsobergrenze | Schülermodell kann die Genauigkeit des Lehrers nicht übertreffen |

| Vererbung von Verzerrungen | Schüler erbt Fehler und Verzerrungen des Lehrers |

Müssen Sie die Bereitstellung Ihres KI-Modells im Labor optimieren, ohne die Nachteile der Destillation in Kauf nehmen zu müssen? KINTEK ist spezialisiert auf die Bereitstellung zuverlässiger Laborgeräte und Verbrauchsmaterialien zur Unterstützung Ihres gesamten Machine-Learning-Workflows, von robuster Computerhardware bis hin zu effizienten Datenverarbeitungstools. Lassen Sie sich von unseren Experten helfen, eine schlankere und effektivere Pipeline aufzubauen. Kontaktieren Sie uns noch heute, um Ihre spezifischen Laboranforderungen zu besprechen!

Visuelle Anleitung

Ähnliche Produkte

Andere fragen auch

- Welche Faktoren beeinflussen Verdunstung und Kondensation? Meistern Sie die Wissenschaft der Phasenübergänge des Wassers

- Was ist die Delta-20-Regel der Verdunstung? Sicher und effektiv sprühen lernen

- Was ist der Unterschied zwischen Cannabisextrakt und Destillat? Ein Leitfaden zu Potenz vs. Vollspektrum-Effekten

- Was ist die Delta-20-Regel? Ein Leitfaden zur Diagnose und Perfektionierung Ihres Espressos

- Was sind die Methoden der Trennung und Reinigung? Meistern Sie die Schlüsseltechniken für Ihr Labor